Мы активно освещаем тему нового алгоритма Apple для обработки личных фотографий. За это время произошло много интересного: от анонса этой функции до оправданий Крейга Федериги и выпуска целого FAQ от Apple, в котором были расписаны все нюансы этой технологии. В общем, чего только там не было. Мы ждали: Apple отказалась от функций поиска детского порно на ваших фотографиях, отложив запуск. Похоже, что обычные пользователи одержали небольшую победу в борьбе за конфиденциальность данных. Мы расскажем вам, что произошло и действительно ли победил здравый смысл.

Похоже, Apple передумала копаться в ваших фотографиях. Или нет?

Почему Apple должна проверять фотографии

Первое объявление о новом алгоритме поиска материалов о сексуальном насилии над детьми под названием CSAM (Материалы о сексуальном насилии над детьми) состоялось 5 августа 2021 года, вызвав мощную негативную реакцию в сети. Функции включали поиск изображений сексуального насилия над детьми с использованием специального алгоритма. Алгоритм также способен блокировать потенциально неприемлемые сообщения, отправляемые в iMessage.

Apple должна полностью отказаться от проверки фотографий

Позже компания пояснила, что обновление затронет только фотографии, загруженные в iCloud от подозреваемых в этом деянии. Компания отрицала, что найденный контент будет доступен ей, Национальному центру по делам пропавших без вести и эксплуатируемых детей (NCMEC) или полиции.

Apple отказалась проверять фотографию. Вот почему

В компании пояснили, что решили приостановить запуск этой функции и отложить внедрение нового алгоритма после большого количества негативных отзывов пользователей. Apple заявляет, что планирует потратить больше времени на разработку и консультации по внедрению нового алгоритма. Несмотря на первоначальные заявления о высокой точности технологии, компания планирует усовершенствовать ее и собрать больше информации для внесения улучшений.

Новый алгоритм будет нагло рыться среди ваших фотографий. Конец уединению?

Это связано с тем, что не злить пользователей и не делать их подозреваемыми — новая функция должна помочь защитить детей и защитить их от опасности, а не отправлять невинных пользователей в тюрьму. Компания не уточняет точный срок, на который откладывается внедрение алгоритма, но говорит, что улучшит его "в ближайшие месяцы". Это правильный шаг, потому что мы говорим не об обычном обновлении iOS, а о свободе людей — нет никакого способа выйти из этого, выпустив обновление.

Кроме того, нет подробного описания того, как компания планирует "консультироваться" и с кем собирать информацию — возможно, это уже каким-то образом влияет на персональные данные пользователей. Вы можете гадать невероятно долго, и только у компании есть точный ответ. Что вы думаете об этом? Напишите нам в чат Telegram, давайте это обсудим.

Как Apple отреагировала на критику CSAM

Возмущение пользователей и широкий общественный резонанс сыграли на руку: выступили эксперты в области информационной безопасности и даже сам Эдвард Сноуден, который призвал Apple остановиться и не внедрять функции. Это правильно, потому что там, где есть поиск запрещенного детского контента, недалеко и до отслеживания пользователей. Компания анонсировала нововведение, пытаясь сделать что-то хорошее, но объяснять принцип его работы начала только спустя некоторое время, выпустив пресс-релизы и целые пояснительные статьи об этом.

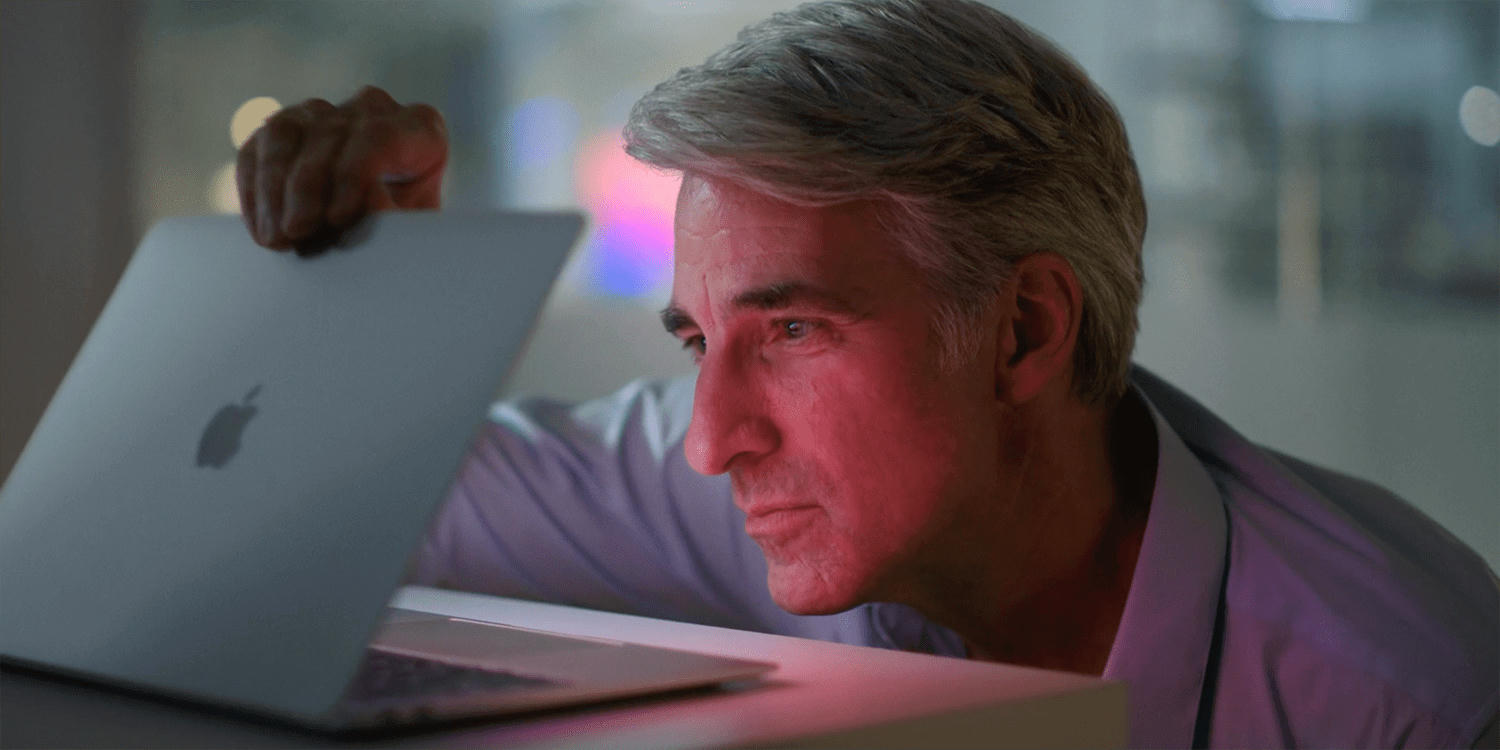

Крейг Федериги пытался всех успокоить, но получилось так себе

Несмотря на жалобы, Крейг Федериги попытался всех успокоить, лично объяснив принцип нового механизма обработки фотографий. Он назвал весь негатив, который обрушился на компанию в результате анонса нововведений, путаницей, и заявил, что пользователи неправильно поняли намерения компании.

Мы хотели бы, чтобы это стало яснее для всех, потому что мы очень позитивно и решительно относимся к тому, что мы делаем и видим, но это неправильно понимают", — сказал Крейг Федериги.

Apple проверит фотографию. Почему это плохо

Компания гордится системами безопасности, которые она обновляет и совершенствует каждый год. Вы сканируете свое лицо с помощью Face ID или прикладываете палец, чтобы разблокировать iPhone с помощью Touch ID. Это защищает устройство от недоброжелателей. Внезапно производитель добавляет функцию, которая способна легко проникнуть в ваше устройство и облачное хранилище, чтобы найти какой-то неприемлемый, по его мнению, контент. Что она с ним сделает?

В чем смысл Touch ID, если Apple может легко проникнуть в ваши фотографии?

Это трудно понять, потому что механизм, по словам компании, будет работать очень точно, но ни Apple, ни полиция, ни правозащитные организации не будут иметь доступа к контенту. Где гарантии того, что алгоритм не украдет данные или личные фотографии пользователей? Как всегда, никаких гарантий нет. Кроме того, это нарушает право пользователей на неприкосновенность персональных данных — понятно, что глупо надеяться на это в 2021 году, но вы просто не должны быть такими высокомерными.

У компании уже есть доступ к пользовательским данным — часть данных зашифрована для защиты от взлома, но по требованию властей Apple легко расшифрует их, потому что корпорации не нужны проблемы с законом и запрет на деятельность. Алгоритм CSAM — хорошая попытка уйти от слежки за пользователями, но он никому не нужен и не нравится. Люди покупают дорогие смартфоны Apple и пользуются услугами компании, которая утверждает, что конфиденциальность является ее сильной стороной. Оказывается, совсем наоборот. Мы ждем продолжения в этой истории.