Редакция gg только вчера сообщила о планах Apple ввести "расширенные меры по защите детей"в свою экосистему. Что ж, сегодня это уже реальность, мифологическая опасность которой раздувается различными СМИ. Давайте разберемся, как работает эта новая система и чем и кому она действительно угрожает.

Apple опубликовала довольно подробную информацию на специальной странице, посвященной этой новой системе. Что там написано?

1. Безопасность связи в сообщениях

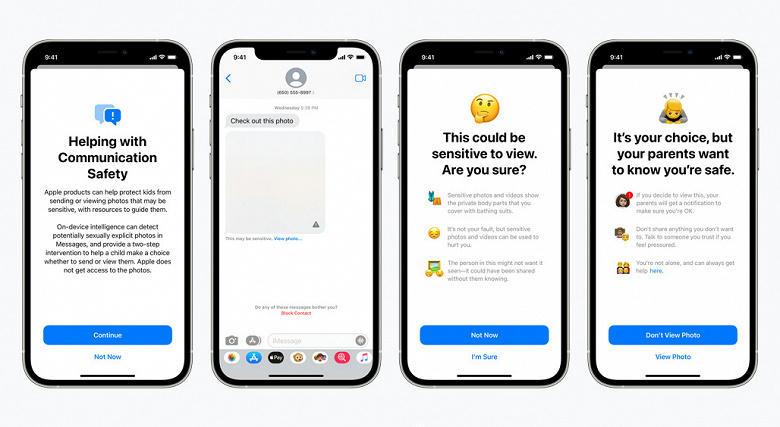

В приложении "Сообщения" появятся новые инструменты для предупреждения детей и их родителей о получении или отправке фотографий сексуального характера.

При получении такого рода контента фотография будет размыта, и ребенок будет предупрежден, ему будут предложены полезные ресурсы и дана гарантия, что все в порядке, если он не хочет просматривать эту фотографию. В качестве дополнительной меры предосторожности ребенку также могут сообщить, что для обеспечения его безопасности его родители получат уведомление, если он все еще будет просматривать эту фотографию.

Аналогичные меры защиты предусмотрены, если ребенок пытается отправить фотографии сексуального характера. Ребенок будет предупрежден перед отправкой фотографии, и родители могут получить сообщение, если ребенок решит отправить его.

Сообщения используют машинное обучение на устройстве для анализа вложений изображений и определения того, является ли фотография откровенной сексуальной. Функция разработана таким образом, что Apple не получает доступа к сообщениям.

2. Обнаружение CSAM (Материалов о сексуальном насилии над детьми)

Еще одной важной проблемой является распространение в Интернете материалов, связанных с сексуальным насилием над детьми (CSAM). CSAM относится к контенту, изображающему откровенные действия сексуального характера с участием ребенка.

Чтобы решить эту проблему, новая технология позволит Apple обнаруживать известные изображения CSAM, хранящиеся в фотографиях iCloud. Это позволит Apple сообщать о таких случаях в Национальный центр по пропавшим без вести и эксплуатируемым детям (NCMEC). NCMEC действует как комплексный центр отчетности CSAM и работает в сотрудничестве с правоохранительными органами по всей территории Соединенных Штатов.

Метод Apple для обнаружения известных CSAMS разработан с учетом конфиденциальности пользователей. Вместо сканирования изображений в облаке система выполняет сопоставление на устройстве, используя базу данных хэшей известных изображений CSAM, предоставленных NCMEC и другими организациями по безопасности детей. Затем Apple преобразует эту базу данных в нечитаемый набор хэшей, который надежно хранится на устройствах пользователей.

Перед сохранением изображения в фотографии iCloud на устройстве выполняется процесс сопоставления этого изображения с известными хэшами CSAM. Этот процесс сопоставления выполняется с использованием криптографической технологии, называемой пересечением частных множеств, которая определяет наличие совпадения без раскрытия результата. Устройство создает криптографический ваучер безопасности, который кодирует результат сопоставления вместе с дополнительными зашифрованными данными об изображении. Этот ваучер загружается в фотографии iCloud вместе с изображением.

Используя другую технологию, называемую пороговым секретным обменом, система гарантирует, что содержимое ваучеров безопасности не может быть интерпретировано Apple до тех пор, пока учетная запись фотографий iCloud не пересечет порог известного содержимого CSAM. Пороговое значение установлено для обеспечения чрезвычайно высокого уровня точности и гарантирует менее одного шанса из одного триллиона в год для ошибочного пометки этой учетной записи.

Только при превышении порогового значения криптографическая технология позволяет Apple интерпретировать содержимое ваучеров безопасности, связанных с соответствующими изображениями CSAM. Затем Apple вручную проверяет каждый отчет, чтобы подтвердить соответствие, отключает учетную запись пользователя и отправляет отчет в NCMEC. Если пользователь считает, что его учетная запись была ошибочно помечена, он может подать апелляцию на восстановление своей учетной записи.

3. Дополнительные советы в Siri и поиске

Apple также расширяет руководство по Siri и поиску, предоставляя дополнительные ресурсы, которые помогут детям и родителям оставаться в безопасности в Интернете и получать помощь в небезопасных ситуациях. Например, пользователи, которые спрашивают Siri, как они могут сообщать о CSAM или эксплуатации детей, будут перенаправлены на ресурсы, где и как подать заявку.

Siri и поиск также обновляются, чтобы вмешиваться, когда пользователи ищут запросы, связанные с CSAM. Эти мероприятия объяснят пользователям, что интерес к этой теме вреден и проблематичен, и предоставят партнерские ресурсы для получения помощи в решении этой проблемы.

Мнение редакции

Редакторы gg хотят обратить ваше внимание на несколько важных моментов:

- Мы не говорим о сканировании всех фотографий, которые хранятся на устройствах пользователей. Существует база данных хэшей уже известных фотографий, изображающих жестокое обращение с детьми. Соответственно, будут сравниваться только те фотографии, в хэше которых есть совпадение с этой базой данных.

- Если будет обнаружено совпадение хэшей, ваша фотография фактически будет отправлена на живой контроллер для просмотра. Но! Контроллеры не будут видеть полное изображение, а только отдельные элементы, которые позволяют им судить о том, есть ли совпадение или несоответствие с фотографией из базы данных CSAM.

- Фактическое сканирование выполняется на устройстве пользователя еще до загрузки фотографии в библиотеку iCloud.

- Отчет о вас как о правонарушителе будет отправлен только после того, как вы превысите определенное пороговое значение для наличия фотографий с жестоким обращением с детьми на вашем устройстве.

- Вся эта система начнет работать только с выпуском iOS 15 и только в США (пока). Более того, если библиотека фотографий iCloud отключена, сканирование вообще не будет выполняться на клиентских устройствах.

Вместо послесловия

Apple уже давно известна своим ревностным отношением к защите пользовательских данных. Несколько лет назад компании пришлось отбиваться от ФБР в суде, и теперь Тим Кук находится в открытой конфронтации с главой Facebook Марком Цукербергом. Конечно, технология хэширования не идеальна, но на данном этапе развития технологий, к сожалению, они не придумали ничего лучшего, чтобы сбалансировать защиту персональных данных и необходимость ужесточения преследования педофилов.

Самое главное: Facebook, Dropbox, Google, Microsoft и другие компании, предоставляющие облачное хранилище для фотографий пользователей, уже давно надежно сканируют их, используя ту же базу данных, к которой теперь подключилась Apple. Dropbox сообщил о 21 000 таких матчей в 2020 году, а тот же Facebook опубликовал ошеломляющую цифру в 15 миллионов матчей еще в 2019 году. Разница лишь в том, что сканирование фотографий всех этих компаний происходит в облаке, а Apple внедряет сканер на уровне операционной системы.

Apple опубликовала подробное описание всего процесса в открытом доступе по ссылке (PDF, 2 МБ).

Источник: apple